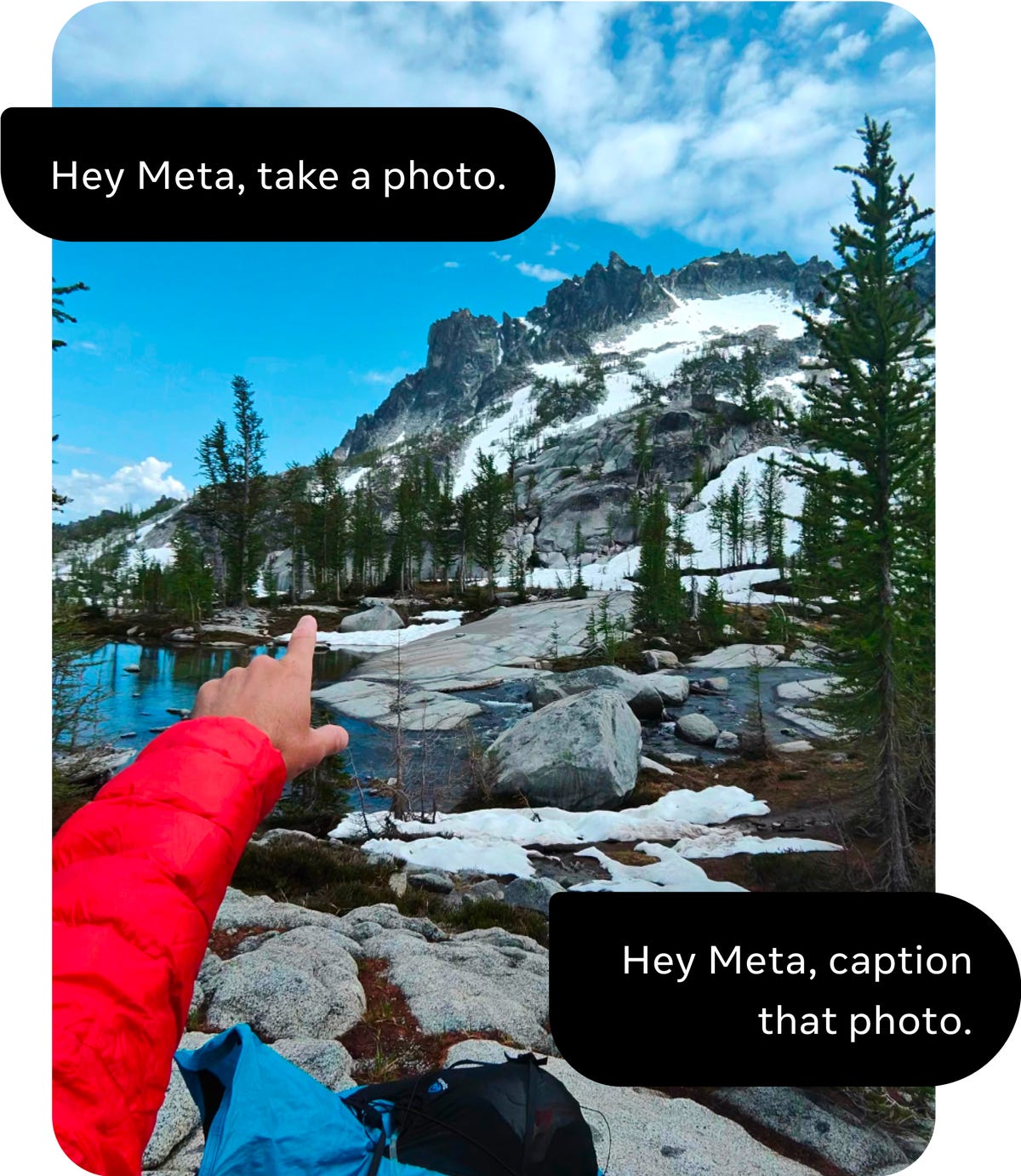

Les lunettes Ray-Ban de Meta intègrent une fonctionnalité expérimentale d’intelligence artificielle (IA) qui permet à l’utilisateur de prendre des photos de son environnement, puis d’obtenir des informations interprétées par l’IA grâce à la reconnaissance d’images. Cette fonctionnalité, annoncée en septembre par le PDG de Meta, Mark Zuckerberg, est désormais déployée sur la deuxième génération de lunettes Ray-Ban de l’entreprise.

Expérience Utilisateur :

L’auteur de l’article a pu tester cette fonctionnalité au siège de Meta à New York. En portant les lunettes Ray-Ban, il a demandé à l’IA de lire les étiquettes de thé devant lui avec les informations cachées à l’encre. L’IA a répondu en indiquant que le thé à la camomille était probablement sans caféine. Cette démonstration a été réalisée grâce à la caméra intégrée aux lunettes, utilisant l’IA générative pour interpréter les images.

Lancement Anticipé et Limites Actuelles :

Meta a lancé cette fonctionnalité plus tôt que prévu, bien qu’elle soit encore en version bêta d’accès anticipé. Actuellement, l’IA ne peut reconnaître que ce que l’utilisateur voit en prenant une photo, qui est ensuite analysée par l’IA. La fonctionnalité nécessite une commande vocale spécifique (“Hey, Meta, look and…”) pour déclencher la prise de photo et la requête à l’IA. Les réponses de l’IA et les images analysées sont stockées dans l’application Meta View associée aux lunettes.

Utilisations Possibles et Perspectives d’Avenir :

Cette IA, appelée “multimodal AI” par Meta en raison de son utilisation combinée de caméras et de chat vocal, constitue une étape vers des AI futures intégrant diverses formes d’entrées sensorielles. Meta prévoit d’améliorer la fluidité de cette technologie au fil du temps et d’explorer des outils AI combinant plusieurs formes de données sensorielles.

Les lunettes Ray-Ban de Meta, avec cette nouvelle fonctionnalité d’IA, marquent une avancée significative dans le domaine des dispositifs portables intelligents. Bien qu’actuellement en version bêta, cette technologie ouvre des perspectives fascinantes pour l’avenir des produits portables dotés de capacités d’assistance accrues grâce à l’IA.

1,104 total views, 1 views today